Openapi mette i superpoteri alle API con MCP

Model Context Protocol: una guida completa su come funziona e come Openapi lo sta utilizzando per API ancora più accessibili.

Model Context Protocol (MCP) è l'hype nel mondo Tech e non solo. Tutti ne parlano: compare nei repository GitHub, nei video su YouTube e sta diventando tema centrale in molti eventi. Ma che cos’è esattamente MCP e perché potrebbe essere effettivamente un game-changer del settore dell’intelligenza artificiale?

Che cos'è il Model Context Protocol (MCP)

Il Model Context Protocol è un protocollo open-source e open standard lanciato da Anthropic nel novembre 2024, azienda leader nel settore AI e concorrente di OpenAI, nota per i suoi modelli LLM chiamati Claude.

L’argomento MCP è però esploso solo alcuni mesi dopo, agli inizi del 2025, con la crescente attenzione agli agenti AI ed anche in seguito alle dichiarazioni sull’utilizzo del MCP di importanti CEO del mondo Tech, come Sam Altman e Sundar Pichai.

MCP è nato per risolvere un problema molto concreto: migliorare la qualità e la pertinenza delle risposte generate dai modelli linguistici di grandi dimensioni (LLM), che spesso soffrono di mancanza di contesto e generano risposte errate o poco rilevanti (le cosiddette “allucinazioni”).

Il Model Context Protocol definisce uno standard universale per come le applicazioni possono fornire contesto agli LLM, facilitando la comunicazione tra modelli e applicazioni basate sull'AI ed ecosistemi dei dati, tool di business e ambienti di sviluppo.

Per questo motivo, MCP viene spesso paragonato ad una “USB-C” per il mondo dell’AI.

Come funziona MCP?

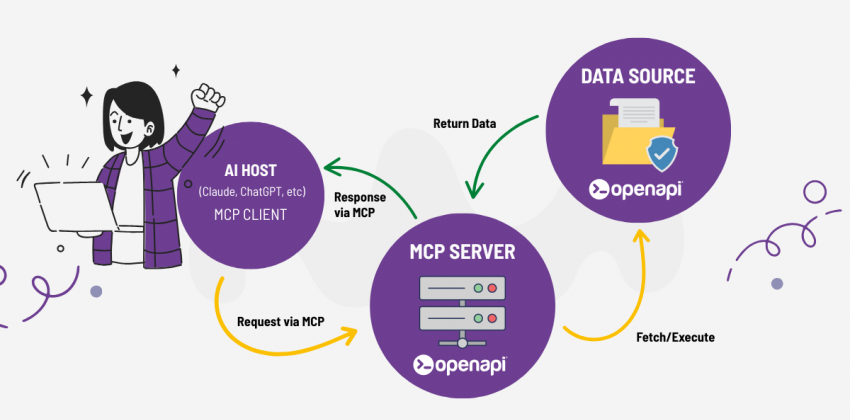

MCP, come anticipato, è uno standard che consente agli sviluppatori di costruire connessioni tra fonti dei dati e tool basati sull'AI. Questi potranno esporre i propri dati tramite server MCP oppure creare applicazioni AI (client MCP) che si connettono a questi server.

MCP adotta un’architettura client-server semplice e modulare:

- LLM: Il modello linguistico di grandi dimensioni che interpreta gli input dell'utente e qualsiasi contesto aggiuntivo.

- Host MCP: l'applicazione che ospita l’LLM

- Client MCP: un componente che mantiene connessioni 1:1 con i server MCP e trasmette il contesto all'LLM.

- Server MCP: un servizio che espone dati, strumenti o funzionalità tramite MCP.

Il server MCP può accedere in sicurezza a file, database o servizi online (come GitHub o API esterne) e fornire queste informazioni in un formato standardizzato al client MCP, che a sua volta le passa all’LLM per arricchire il contesto e migliorare la risposta.

Perché MCP è importante per gli sviluppatori

Prima dell’introduzione di MCP, ogni applicazione o modello AI doveva integrare separatamente ogni singola fonte di dati o strumento, affrontando il complesso problema dell’integrazione “M×N” (dove M rappresenta le applicazioni e N le fonti). MCP semplifica radicalmente questo scenario, trasformandolo in un problema “M+N” e rendendo lo sviluppo molto più efficiente.

Gli sviluppatori di soluzioni AI non dovranno più creare interfacce per ogni specifico modello o fonte di dati ma potranno creare facilmente agenti o workflow ad un livello superiore rispetto agli LLM. Potranno cambiare modelli AI o strumenti in modo estremamente facile senza dover riscrivere codice e senza dipendere da uno specifico fornitore.

MCP ed API: quali sono le differenze?

MCP e API REST possono sembrare simili perché entrambi permettono di fare richieste a servizi esterni, ma differiscono sostanzialmente.

Una delle più importanti distinzioni, è la modalità in cui vengono effettuate richieste e soprattutto la gestione della risposta. Nel caso, ad esempio, di una REST API le richieste sono effettuate tramite endpoint con dei parametri richiesti ed una risposta ben definita, ma non c’è nessuna possibilità di interpretare la risposta.

MCP si differenzia da questo approccio perché consente di effettuare richieste anche tramite prompt con linguaggio naturale e offre il contesto aggiuntivo agli LLM per ragionare su quando e perché invocare gli strumenti, consentendo una logica orientata agli obiettivi.

Un’altra importante differenza è che MCP è uno standard orientato alle sessioni che consente agli agenti AI di mantenere dialoghi persistenti e ricchi di contesto con i servizi di backend.

A differenza delle API REST stateless, MCP conserva:

- Memoria di sessione tra le interazioni

- Chiamate strutturate di strumenti per operazioni complesse

- Supporto dello streaming tramite Server-Sent Events (SSE) o HTTP

Ma le API, come anticipato, possono essere anche parte integrante degli strumenti disponibili tramite un server MCP. Ad esempio, quando un LLM decide quale strumento utilizzare, tale strumento può includere l'invio di una determinata richiesta API e la successiva fornitura della risposta all'LLM.

Casi di utilizzo del MCP: da Github a Salesforce, da Postman a Canva

L’adozione di MCP apre opportunità straordinarie anche in settori non strettamente tecnici.

Gli sviluppatori, ad esempio, possono sfruttare agenti AI per revisionare e scrivere codice, accedendo facilmente ad ambienti di lavoro come GitHub per identificare errori, effettuare debug e automatizzare task ripetitivi.

Ma il potenziale di MCP va ben oltre lo sviluppo software. Potrà essere utilizzato anche in contesti non prettamente di sviluppo ad esempio per la redazione di contenuti specialistici o la gestione dell’assistenza clienti, grazie all’accesso a documentazione tecnica e informazioni di prodotto.

Nelle ultime settimane, molte aziende hanno annunciato l’integrazione del nuovo protocollo MCP nei propri processi.

Salesforce, ad esempio, semplifica l’accesso e l’interazione con i propri dati e strumenti. I team aziendali possono consultare i dati del CRM in modo sicuro tramite agenti AI, senza necessità di licenza o formazione specifica. Gli sviluppatori possono automatizzare attività come deploy, query e test tramite prompt intelligenti integrati nei loro ambienti di sviluppo. I responsabili IT, infine, beneficiano di un sistema centralizzato di governance che consente di gestire policy, permessi e accessi in modo sicuro su tutti i connettori MCP.

Anche GitHub ha adottato MCP per automatizzare attività legate al codice, integrare strumenti esterni sfruttando il contesto e le funzionalità AI di GitHub, e attivare flussi di lavoro nel cloud accessibili da qualsiasi dispositivo, senza configurazioni locali.

Postman invece permette ora di creare agenti MCP in modo visuale, senza codice server né hosting. Con un clic si avvia tutto in pochi secondi, ed è possibile testarli subito o integrarli con Agent Mode o altri agenti conversazionali tramite supporto remoto MCP.

Infine, grazie all’integrazione con MCP, sarà presto possibile creare e modificare progetti Canva direttamente dalla chat. Basterà un comando all’assistente AI per generare presentazioni, ridimensionare, importare o esportare risorse, senza uscire dalla conversazione.

Come Openapi sta implementando l’MCP per le sue applicazioni

Siamo lieti di anticipare un importante sviluppo per Openapi: il nostro team tecnico è attualmente impegnato nella realizzazione di un server MCP Openapi, una delle tecnologie più innovative nel panorama dell’intelligenza artificiale applicata alle API.

Grazie a questa nuova infrastruttura, le applicazioni AI saranno in grado di interagire in tempo reale con la nostra libreria di API, eseguendo richieste complesse in modo naturale, contestuale e completamente automatizzato. Ciò significa che sarà possibile, ad esempio:

-

richiedere e accedere ad oltre 400 servizi API e a milioni di dati con un semplice prompt testuale,

-

generare, filtrare e arricchire informazioni in modo dinamico,

-

integrare workflow intelligenti con sistemi esterni senza scrivere codice complesso,

- supportare agenti AI conversazionali nella gestione di attività API-based.

Il server MCP di Openapi aprirà la strada a nuovi scenari di utilizzo delle nostre API, semplificando l’integrazione nei sistemi AI e velocizzando i processi di sviluppo, sperimentazione e automazione.

Presto condivideremo ulteriori dettagli sul rilascio, la documentazione tecnica e le prime integrazioni disponibili.